边缘计算网络架构概述

边缘计算网络架构是一种分布式计算模型,它将数据处理和存储功能从云端下沉到网络边缘。这种架构的核心优势在于能够显著降低网络延迟,提高数据处理效率。与传统的云计算相比,边缘计算网络架构更注重本地化处理,使得数据在产生源头就能得到快速响应。

在物联网(IoT)和5G时代,边缘计算网络架构的重要性日益凸显。它通过将计算资源部署在靠近数据源的位置,有效解决了数据传输瓶颈问题。这种架构不仅能够支持实时性要求高的应用场景,还能显著降低网络带宽成本。

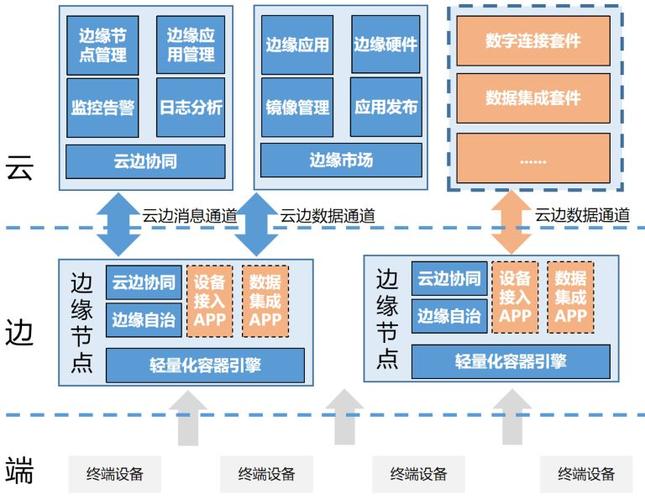

边缘计算网络架构的设计需要考虑多个维度,包括计算能力、存储资源和网络连接。它通常由边缘节点、边缘网关和云端服务器三个层次构成,每个层次都有其特定的功能定位和技术要求。

边缘计算与传统云计算的对比

边缘计算网络架构与传统云计算在多个方面存在显著差异。在数据处理位置上,边缘计算强调本地处理,而云计算则依赖集中式的数据中心。这种差异直接影响了系统的响应速度和数据处理效率。

在网络带宽需求方面,边缘计算能够显著降低对网络带宽的依赖。通过本地处理数据,减少了需要传输到云端的数据量,这对于带宽受限的应用场景尤为重要。

在系统可靠性方面,边缘计算网络架构表现出更强的容错能力。即使与云端的连接中断,边缘节点仍能独立运行,确保关键业务的连续性。

边缘计算网络架构的层次化设计

边缘计算网络架构通常采用三层设计模型。第一层是边缘设备层,包括各种物联网终端设备,负责数据采集和初步处理。这一层的设计需要考虑设备的计算能力和能耗限制。

第二层是边缘网关层,作为连接边缘设备和云端的桥梁,负责数据的汇聚、处理和转发。这一层的设计需要平衡计算性能和网络传输效率。

第三层是云端服务层,提供强大的计算和存储能力,支持复杂的数据分析和长期存储。这一层与边缘层的协同工作,构成了完整的边缘计算网络架构。

边缘计算网络架构的关键技术

在边缘计算网络架构中,容器技术扮演着重要角色。通过将应用打包成轻量级的容器,可以实现快速部署和弹性扩展,满足边缘计算场景的动态需求。

边缘缓存技术是另一个关键技术,它通过在边缘节点存储常用数据,减少对云端的数据请求,从而降低网络延迟。这种技术特别适用于内容分发等应用场景。

边缘智能技术的发展使得边缘节点能够进行本地化的机器学习推理,这不仅提高了数据处理速度,还增强了数据隐私保护。

边缘计算网络架构的应用场景

在智能制造领域,边缘计算网络架构支持实时监控和预测性维护。通过在生产设备附近部署边缘计算节点,可以快速处理传感器数据,及时发现设备异常。

在智慧城市建设中,边缘计算网络架构能够支持大规模的物联网设备连接,实现交通管理、环境监测等应用的实时响应。

在自动驾驶领域,边缘计算网络架构为车辆提供了低延迟的决策支持系统,确保行车安全的同时,减少了云端依赖。

边缘计算网络架构的挑战与对策

边缘计算网络架构面临着安全性挑战。由于边缘节点通常部署在不受控的环境中,容易受到物理攻击和网络攻击。因此,需要采用多层次的安全防护机制,包括硬件加密和软件认证。

另一个挑战是资源管理。边缘节点的计算和存储资源有限,如何高效分配这些资源是系统设计的关键。采用智能调度算法和动态资源分配策略可以有效解决这一问题。

标准统一也是边缘计算网络架构面临的重要问题。目前,不同厂商的边缘计算解决方案存在兼容性问题,这需要产业界共同努力,推动标准的制定和统一。

边缘计算网络架构的未来发展趋势

未来,边缘计算网络架构将朝着智能化方向发展。通过集成人工智能算法,边缘节点将具备更强的自主决策能力,能够处理更复杂的任务。

另一个趋势是边缘协同计算。多个边缘节点之间将形成计算集群,共同完成复杂的计算任务,这种架构将进一步提高系统的计算能力和可靠性。

边缘即服务(Edge-as-a-Service)模式也将得到发展。通过将边缘计算能力以服务的形式提供,用户可以更灵活地使用边缘计算资源,降低部署成本。

边缘计算网络架构的优化策略

优化边缘计算网络架构的关键在于负载均衡。通过智能调度算法,可以在多个边缘节点之间合理分配计算任务,避免单个节点过载。

另一个优化策略是数据压缩。在数据传输过程中,采用高效的数据压缩算法,可以减少网络带宽占用,提高传输效率。

缓存优化也是重要的优化方向。通过分析数据访问模式,合理设置缓存策略,可以提高数据访问速度,降低云端访问频率。

边缘计算网络架构作为新一代计算范式,正在深刻改变数据处理和传输的方式。通过将计算能力下沉到网络边缘,它不仅解决了传统云计算面临的延迟和带宽问题,还为物联网、智能制造等领域带来了新的发展机遇。未来,随着技术的不断进步,边缘计算网络架构将在更多领域发挥重要作用,推动数字化转型的深入发展。参考文献:

Shi W, Cao J, Zhang Q, et al. Edge Computing: Vision and Challenges[J]. IEEE Internet of Things Journal, 2

016, 3(5): 637-646.