什么是robots.txt文件?

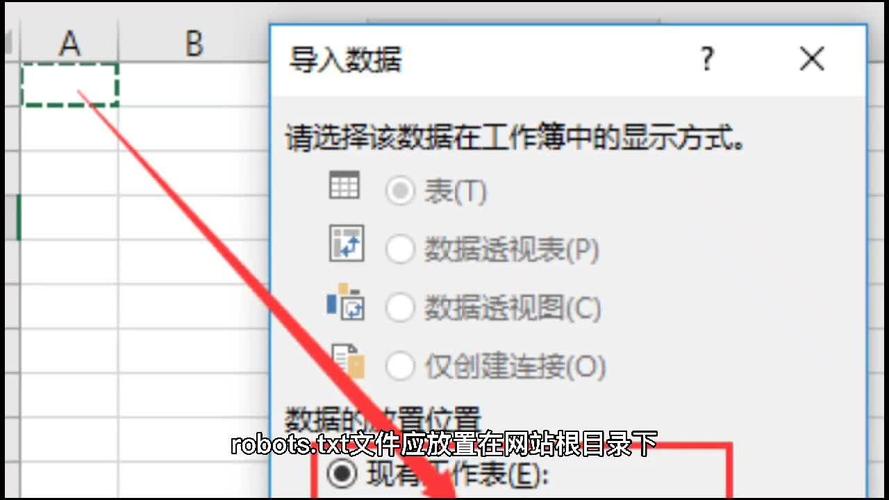

robots.txt文件是一个位于网站根目录下的纯文本文件,用于向搜索引擎爬虫发出指令,告知它们哪些页面可以抓取,哪些页面应该避免访问。通过合理配置robots.txt文件,网站管理员可以控制搜索引擎对网站内容的访问权限,从而优化搜索引擎的抓取效率。

优化robots.txt文件的关键步骤

1. 确定需要屏蔽的页面

在优化robots.txt文件时,需要明确哪些页面不希望被搜索引擎抓取。这些页面可能包括后台管理页面、用户个人数据页面、测试页面等。通过将这些页面添加到robots.txt文件的屏蔽列表中,可以有效防止敏感信息被搜索引擎索引。

2. 允许搜索引擎抓取重要页面

在屏蔽无关页面的同时,确保搜索引擎能够顺利抓取网站的重要页面至关重要。这包括首页、产品页面、博客文章等。通过合理配置robots.txt文件,可以引导搜索引擎优先抓取这些关键页面,从而提升网站在搜索结果中的排名。

高级优化技巧

1. 使用通配符进行批量屏蔽

在robots.txt文件中,可以使用通配符(如)来批量屏蔽或允许特定类型的页面。,使用"Disallow: /admin/"可以屏蔽所有以/admin/开头的页面,而使用"Allow: /blog/"则可以允许所有以/blog/开头的页面被抓取。

2. 指定搜索引擎爬虫

robots.txt文件还可以针对特定的搜索引擎爬虫进行配置。,使用"User-agent: Googlebot"可以专门针对Google爬虫发出指令,而使用"User-agent: "则适用于所有搜索引擎爬虫。通过针对不同爬虫进行定制化配置,可以进一步优化搜索引擎的抓取效果。

常见问题解答

1. 如何检查robots.txt文件是否生效?

可以使用Google Search Console等工具来检查robots.txt文件的配置是否生效。这些工具会模拟搜索引擎爬虫的行为,显示哪些页面被允许抓取,哪些页面被屏蔽。

2. 优化robots.txt文件后,需要多久才能看到效果?

优化robots.txt文件后,通常需要等待搜索引擎重新抓取网站才能看到效果。这个过程可能需要几天到几周不等,具体时间取决于搜索引擎的抓取频率。

3. 是否可以完全依赖robots.txt文件来控制搜索引擎抓取?

虽然robots.txt文件是控制搜索引擎抓取的重要工具,但它并不能完全替代其他SEO优化措施。,即使某个页面被robots.txt文件允许抓取,如果该页面的内容质量不高,仍然可能无法获得良好的搜索排名。

通过以上步骤和技巧,您可以有效地优化robots.txt文件,提升网站的SEO表现。记住,robots.txt文件只是SEO优化的一部分,结合其他优化措施,才能真正实现网站的长期成功。