Python性能瓶颈分析

在优化Python性能之前,需要了解Python的性能瓶颈所在。Python作为解释型语言,其执行速度通常比编译型语言慢。这主要源于Python的动态类型特性、全局解释器锁(GIL)以及内存管理机制。通过使用cProfile、timeit等工具,可以准确测量代码执行时间,找出性能热点。值得注意的是,80%的运行时间往往集中在20%的代码上,这就是著名的80/20法则。因此,优化工作应该集中在这些热点代码上,而不是盲目优化整个程序。

Python代码层面的优化

选择合适的数据结构

数据结构的选择对Python性能影响巨大。列表(list)适合顺序访问和修改,但在查找操作上效率较低;集合(set)和字典(dict)基于哈希表实现,查找速度极快;元组(tuple)比列表更轻量,适合存储不变数据。,成员检查操作在列表中时间复杂度为O(n),而在集合中仅为O(1)。使用collections模块中的deque、defaultdict等专用数据结构,可以进一步提升特定场景下的性能。

循环与迭代优化

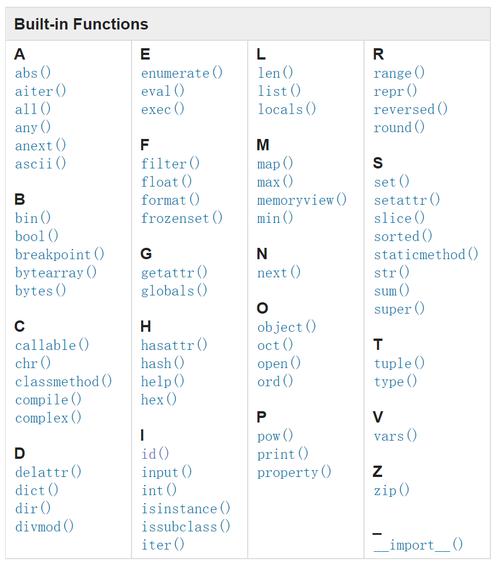

Python中的循环往往是性能瓶颈所在。应尽量避免在循环中进行不必要的计算或函数调用。使用列表推导式通常比显式循环更快,因为列表推导式在C层面实现。对于大数据集,生成器表达式比列表推导式更节省内存。map()和filter()函数在某些情况下也能提供更好的性能。尽量减少循环嵌套,考虑是否可以用内置函数或NumPy等库的向量化操作替代循环。

高级Python性能优化技术

使用C扩展和Cython

对于计算密集型任务,可以考虑将关键部分用C语言重写,通过Python的C扩展接口调用。Cython是一个强大的工具,它允许将Python代码编译为C扩展,同时支持类型声明以获得接近C语言的性能。通过添加静态类型声明,Cython代码可以比纯Python代码快数十倍甚至数百倍。NumPy和Pandas等流行库的核心部分就是用C/C++实现的,这也是它们性能优异的原因。

并发与并行编程

由于GIL的存在,Python的多线程并不适合CPU密集型任务。对于I/O密集型任务,多线程仍然有效。multiprocessing模块可以绕过GIL限制,实现真正的并行计算,但进程间通信开销较大。concurrent.futures模块提供了更高级的线程/进程池接口。对于现代Python版本,asyncio提供了高效的异步I/O支持,特别适合高并发的网络应用。选择合适的并发模型对性能提升至关重要。

Python性能优化工具

Python生态系统提供了丰富的性能分析和优化工具。除了内置的timeit和cProfile外,第三方工具如Py-Spy可以进行低开销的采样分析,line_profiler可以逐行分析函数性能,memory_profiler用于分析内存使用情况。对于科学计算,使用NumPy和Pandas的向量化操作可以大幅提升性能。PyPy作为Python的替代实现,其JIT编译器可以显著提升某些类型代码的执行速度,特别是在长时间运行的应用程序中。

Python性能优化是一个需要综合考虑多方面因素的工程问题。通过理解Python的运行机制,合理使用各种优化技术和工具,开发者可以显著提升Python程序的执行效率。值得注意的是,优化应该在保证代码可读性和可维护性的前提下进行,避免过早优化和过度优化。随着Python语言的不断发展,新的性能优化技术也在不断涌现,保持学习和实践是提升Python性能优化能力的关键。

常见问题解答

Q1: Python为什么比C/C++慢?

A1: Python比C/C++慢的主要原因包括:解释执行而非编译执行、动态类型检查、内存自动管理、全局解释器锁(GIL)等。这些特性虽然提高了开发效率,但也带来了性能开销。

Q2: 如何快速找出Python代码的性能瓶颈?

A2: 可以使用Python内置的cProfile模块或第三方工具如Py-Spy进行性能分析。对于函数级别的测量,timeit模块非常有用。line_profiler可以显示每行代码的执行时间,帮助精确定位热点。

Q3: 什么情况下应该考虑使用Cython?

A3: 当纯Python代码中的计算密集型部分成为性能瓶颈时,可以考虑使用Cython。特别是涉及大量数值计算、循环或需要与C/C++库交互的场景,Cython通常能带来显著的性能提升。

Q4: Python多线程和多进程如何选择?

A4: 对于I/O密集型任务,多线程是更好的选择,因为线程创建和切换开销小。对于CPU密集型任务,由于GIL的限制,应该使用多进程来实现真正的并行计算。concurrent.futures模块提供了统一的接口来管理线程池和进程池。