算法偏见的来源

算法偏见的来源多种多样,主要包括数据偏见、模型偏见和评估偏见。数据偏见是最常见的来源之一,通常由于训练数据中某些群体的代表性不足或历史数据中固有的歧视性模式导致。,在招聘算法中,如果历史数据中女性被录用的比例较低,算法可能会学习到这种模式,从而在未来的决策中继续歧视女性候选人。

模型偏见

模型偏见指的是算法本身的设计或参数选择导致的偏见。,某些模型可能对输入数据的某些特征过于敏感,从而放大这些特征的影响。这种偏见通常在模型训练过程中被引入,尤其是在特征选择或损失函数设计不当的情况下。

评估偏见

评估偏见则源于评估标准的不完善。如果评估指标未能充分考虑不同群体的公平性,算法可能会在某个群体上表现良好,而在其他群体上表现不佳。,在医疗诊断算法中,如果评估标准主要关注整体准确率,而忽略了对少数群体的诊断准确性,可能会导致对这些群体的误诊率较高。

算法偏见检测的方法

检测算法偏见需要综合运用多种技术和方法。以下是一些常用的检测方法:

统计分析方法

统计分析方法通过比较算法在不同群体上的表现来检测偏见。,可以计算算法在不同性别、种族或年龄组上的准确率、召回率等指标,如果发现显著差异,则可能存在偏见。常用的统计检验方法包括t检验、卡方检验等。

公平性度量

公平性度量是专门设计用于评估算法公平性的指标。常见的公平性度量包括 demographic parity、equalized odds、predictive parity等。这些度量从不同角度衡量算法决策的公平性,帮助识别潜在的偏见。

对抗性测试

对抗性测试通过构造特定的输入数据来测试算法的鲁棒性和公平性。,可以生成一些微扰数据,观察算法输出的变化,如果发现算法对某些群体的输入特别敏感,则可能存在偏见。对抗性测试可以帮助发现模型中的潜在漏洞。

应对算法偏见的策略

一旦检测到算法偏见,需要采取相应的策略来减轻或消除这些偏见。以下是一些有效的应对策略:

数据预处理

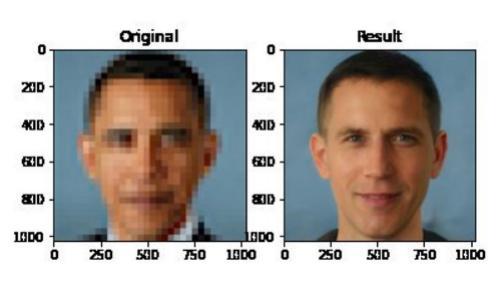

数据预处理旨在消除训练数据中的偏见。常见的方法包括重新采样(oversampling或undersampling)、数据增强、以及使用生成对抗网络(GAN)生成平衡数据。这些方法可以帮助改善数据中不同群体的代表性。

算法调整

算法调整通过修改模型的设计或训练过程来减少偏见。,可以在损失函数中加入公平性约束,或者在模型训练过程中使用对抗训练来强制模型学习公平的表示。这些方法直接从模型层面入手,提高算法的公平性。

后处理方法

后处理方法在模型输出上进行调整,以纠正潜在的偏见。,可以对模型的预测结果进行校准,或者使用阈值调整来平衡不同群体的输出分布。后处理方法通常计算成本较低,适合在模型部署后使用。

常见问题解答

1. 算法偏见检测的难点是什么?

算法偏见检测的主要难点在于偏见的多样性和隐蔽性。不同类型的偏见可能需要不同的检测方法,而某些偏见可能非常细微,难以通过常规方法发现。偏见检测通常需要领域知识和上下文理解,这也增加了检测的复杂性。

2. 如何确保算法偏见检测的全面性?

确保全面性需要综合运用多种检测方法,并结合领域专家的知识。,可以同时使用统计分析、公平性度量和对抗性测试,从不同角度评估算法的公平性。定期更新检测方法和评估标准也很重要,以适应不断变化的算法和应用场景。

3. 算法偏见检测在实际应用中的重要性是什么?

算法偏见检测在实际应用中至关重要,因为偏见的算法可能导致严重的社会不公和经济损失。,在招聘、贷款审批、司法判决等领域,偏见的算法可能对某些群体造成系统性歧视。通过检测和纠正这些偏见,可以确保算法决策的公正性,增强公众对人工智能技术的信任。

算法偏见检测是确保人工智能技术公平、透明和可靠的关键步骤。通过理解偏见的来源、掌握检测方法并采取有效的应对策略,我们可以最大限度地减少算法偏见带来的负面影响。未来,随着技术的进步和社会的关注,算法偏见检测将变得更加精细和全面,为构建公平的人工智能生态系统奠定坚实基础。